如何不删除AI应用程序?深层追求基础和数据库是

栏目:媒体新闻 发布时间:2025-05-25 09:52

像2025年一样,生成AI模型的功能仍在迅速改善。如果您关注这一领域,您会发现许多企业家在工作上花费了很多精力...

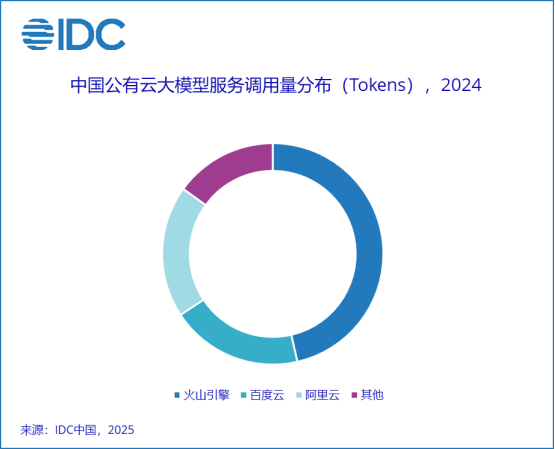

像2025年一样,生成AI模型的功能仍在迅速改善。如果您关注这一领域,您会发现许多企业家花了很多精力来创建AI应用程序,但是通常会迅速被新一代大型模型的“本地功能”取代。这种类型的应用程序被归类为包装层的提示(提示字)应用程序。这些应用程序通过设计及时的单词来呼吁大型模型的基本技能,但不会建立更深入的业务。由于应用程序的价值主要取决于原始模型的原始能力,因此可以很容易地更换大型模型,以继续更强大。如何开发大型模型不容易“旅行”的AI应用程序?在这方面,Ex Overvesperto的技术英特尔表示,大型应用模型的开发不仅应扩大大型模型本身的功能,而且还应直接开发基于代理的能力在大型型号上,以便可以轻松地将其删除,因为大型模型的功能有所提高。模型的大规模模型开发应从大型模型不好或无法克服的点开始,例如解决数据基础问题。当前大型模型的两个最明显的问题与数据相关联。首先要携带的是幻觉。大型模型本质上是生产可能性操作。输出的内容越多,可能性的偏差就越大。此外,培训数据的质量也可能导致幻觉。为了在短期内完全消除幻觉问题,需要进行关键的技术变化。其次,大型模型的知识不能实时更新。大概几个月甚至几年前,有固定的时间进行大型模型进行预培训,您不知道发生了什么,不会根据时间更新您的知识。答案使C唯一的基于旧的已知内容。为了应对这两个主要问题,该行业达成共识是为了产生基于抹布的知识库(获得一系列增强)。它根据预先训练的大型模型连接外部数据源。所有任务和答案都是从知识的基础上获得的,然后是大型模型的答案。在特定的操作中,企业需要将内部文档转换为themachine可以理解的表格。该文档首先被划分,然后对矢量进行,并最终存储在矢量数据库中。当用户询问时,问题也会转换为向量,根据它们在矢量数据库中搜索,并最终根据获得的内容生成响应。记忆和准确性是形成响应时非常关键的指标。回忆看一下获得多少“真正相关”的文档。准确性是查看多少获得的文档“真正相关”。英特尔专家说,当您看到这些技术细节时,您应该意识到,大型模型的影响会受到许多因素或链接的影响。例如,GEM的选择负责将文本转换为向量,文档大小段,数据提取处理等。正如英特尔的专家所看的那样,进行大型模型开发可能不是直接从代理商开始的最喜欢的程序。基于数据的部分差异会导致更严重的最终效果。换句话说,如果数据本身可以正确处理,而不是仅依靠大型模型本身的性能,它将创造出更加无形的。快速开始并在云中企业的发展层面中发展环境。目前,许多大型国内外公司都根据大型的破布和破布技术建立了商业知识库,许多前线员工都得到了认可。鉴于玻璃知识的基础非常对于企业而言,火山引擎推出了支持抹布场景的云主机镜像。火山发动机在大型模型服务领域表现出色。根据IDC发布的“公共云大型型号服务市场结构的分析,第1季度”的报告,火山引擎是公共云的第一个市场排名。新推出的抹布镜允许普通开发人员开发AI应用程序,这些应用程序不容易被较低阈值的大型模型“捕获”。抹布图像不仅包含嵌入模块,还包含一个向量数据库,重新排列模型和7B的Depsek蒸馏模型。它还在前面提供数据预处理服务,模块和页面以处理在线问答服务,并且所有软件堆栈均提前进行了优化。作为面向企业的服务冰,火山引擎抹布图像是指OPEA架构。 OPEA是去年Intel发起的开放社区来源,使用开放的体系结构和模块化组件来帮助企业开发AI应用程序扩展的衡量基础。与普通的开放资源体系结构相比,火山引擎的图像具有更多的业务水平功能。许多云制造商还提供抹布服务,为普通用户提供较低的阈值,但是对于专业开发人员来说,这些“黑匣子”阻止了许多技术细节。作为一种开放的资源解决方案,火山引擎抹布图像为开发人员提供了更多细节,并从许多技术维度中进行了优化,从而开发了真正的技术障碍。 DeepSeek流行后,许多公司正计划在本地部署。市场上有许多解决方案。一对一的高性能图形卡通常有8张。该解决方案的成本不低。在清洁bu之前智慧需求,投资一千美元的成本可能并不明智。如今,用户只需要选择虚拟机和火山发动机玻璃即可在三分钟内生成开发环境,并开始不同的研究和技能。为了帮助开发人员提高其功能,英特尔还准备了一系列课程,以帮助所有人 - 与 - 交易知识,并更轻松地将第一步从0到1,从而为数据奠定了坚实的基础。开发大型模型应用程序的三个要素,硬件平台是基础,英特尔专家总结了大型模型应用程序开发的三个要素。除了软件堆栈并支持今天提到的指南课程外,硬件环境也很重要。该火山引擎已根据英特尔Xeon的英特尔处理器建造了各种云主机。最近,由G4IL的一般目标示例推出,该示例基于Intel Xeon 6 Performance Core Processor,SuipablE对于应用程序的开发。G4IL是火山引擎的第四代一般客观示例,其中“ G”代表一般目标“ 4”代表第四代,而“ I”代表了Intel CPU的平台。与第三代相比,在数据库应用程序,Web应用程序和图像渲染中,其整体性能得到了显着改善,其对AI识别的好处尤其出色。多亏了集成的AMX加速器,Intel Xeon 6处理器已成为最能识别AI的X86建筑处理器之一。在G4IL的火山引擎的示例中,用户可以使用CPU完成AI识别。与基于GPU的解决方案相比,它具有较低成本的好处,并且更容易获得资源,并且可以满足基本需求。基于CPU的破坏解决方案特别适合于AI应用的发展阶段和验证。和上面提到的火山引擎抹布镜,用户是Maait迅速为大型云应用程序开发了一个发展环境,从而大大降低了硬件资源的阈值。当涉及劳动过程时,通常有必要使用CPU + GPU计算的异质体系结构。例如,具有AMX的Xeon CPU可用于处理轻巧的AI负载,例如嵌入,重新排列和矢量数据库,从而使GPU专注于处理重型AI负载,从而改善了资源使用和一般处理能力。 G4IL的亮点是,用户只需要选择配备16个VCPU或32 VCPU的云主机,并且即使不使用GPU,也可以使用具有7或14B的蒸馏版本的型号。值得一提的是,该解决方案还支持DeepSeek BF16推荐的高准确计算格式,这进一步提高了构想的质量。摘要:一旦技术进化就是RapiD,在云平台的帮助下开发不仅降低了反复试验成本,而且还可以加速变化,从而为企业和开发人员提供更灵活的选择。更重要的是,通过完善破布和其他技术,我们可以创建不容易被大型模型“捕获”的AI应用程序。

像2025年一样,生成AI模型的功能仍在迅速改善。如果您关注这一领域,您会发现许多企业家花了很多精力来创建AI应用程序,但是通常会迅速被新一代大型模型的“本地功能”取代。这种类型的应用程序被归类为包装层的提示(提示字)应用程序。这些应用程序通过设计及时的单词来呼吁大型模型的基本技能,但不会建立更深入的业务。由于应用程序的价值主要取决于原始模型的原始能力,因此可以很容易地更换大型模型,以继续更强大。如何开发大型模型不容易“旅行”的AI应用程序?在这方面,Ex Overvesperto的技术英特尔表示,大型应用模型的开发不仅应扩大大型模型本身的功能,而且还应直接开发基于代理的能力在大型型号上,以便可以轻松地将其删除,因为大型模型的功能有所提高。模型的大规模模型开发应从大型模型不好或无法克服的点开始,例如解决数据基础问题。当前大型模型的两个最明显的问题与数据相关联。首先要携带的是幻觉。大型模型本质上是生产可能性操作。输出的内容越多,可能性的偏差就越大。此外,培训数据的质量也可能导致幻觉。为了在短期内完全消除幻觉问题,需要进行关键的技术变化。其次,大型模型的知识不能实时更新。大概几个月甚至几年前,有固定的时间进行大型模型进行预培训,您不知道发生了什么,不会根据时间更新您的知识。答案使C唯一的基于旧的已知内容。为了应对这两个主要问题,该行业达成共识是为了产生基于抹布的知识库(获得一系列增强)。它根据预先训练的大型模型连接外部数据源。所有任务和答案都是从知识的基础上获得的,然后是大型模型的答案。在特定的操作中,企业需要将内部文档转换为themachine可以理解的表格。该文档首先被划分,然后对矢量进行,并最终存储在矢量数据库中。当用户询问时,问题也会转换为向量,根据它们在矢量数据库中搜索,并最终根据获得的内容生成响应。记忆和准确性是形成响应时非常关键的指标。回忆看一下获得多少“真正相关”的文档。准确性是查看多少获得的文档“真正相关”。英特尔专家说,当您看到这些技术细节时,您应该意识到,大型模型的影响会受到许多因素或链接的影响。例如,GEM的选择负责将文本转换为向量,文档大小段,数据提取处理等。正如英特尔的专家所看的那样,进行大型模型开发可能不是直接从代理商开始的最喜欢的程序。基于数据的部分差异会导致更严重的最终效果。换句话说,如果数据本身可以正确处理,而不是仅依靠大型模型本身的性能,它将创造出更加无形的。快速开始并在云中企业的发展层面中发展环境。目前,许多大型国内外公司都根据大型的破布和破布技术建立了商业知识库,许多前线员工都得到了认可。鉴于玻璃知识的基础非常对于企业而言,火山引擎推出了支持抹布场景的云主机镜像。火山发动机在大型模型服务领域表现出色。根据IDC发布的“公共云大型型号服务市场结构的分析,第1季度”的报告,火山引擎是公共云的第一个市场排名。新推出的抹布镜允许普通开发人员开发AI应用程序,这些应用程序不容易被较低阈值的大型模型“捕获”。抹布图像不仅包含嵌入模块,还包含一个向量数据库,重新排列模型和7B的Depsek蒸馏模型。它还在前面提供数据预处理服务,模块和页面以处理在线问答服务,并且所有软件堆栈均提前进行了优化。作为面向企业的服务冰,火山引擎抹布图像是指OPEA架构。 OPEA是去年Intel发起的开放社区来源,使用开放的体系结构和模块化组件来帮助企业开发AI应用程序扩展的衡量基础。与普通的开放资源体系结构相比,火山引擎的图像具有更多的业务水平功能。许多云制造商还提供抹布服务,为普通用户提供较低的阈值,但是对于专业开发人员来说,这些“黑匣子”阻止了许多技术细节。作为一种开放的资源解决方案,火山引擎抹布图像为开发人员提供了更多细节,并从许多技术维度中进行了优化,从而开发了真正的技术障碍。 DeepSeek流行后,许多公司正计划在本地部署。市场上有许多解决方案。一对一的高性能图形卡通常有8张。该解决方案的成本不低。在清洁bu之前智慧需求,投资一千美元的成本可能并不明智。如今,用户只需要选择虚拟机和火山发动机玻璃即可在三分钟内生成开发环境,并开始不同的研究和技能。为了帮助开发人员提高其功能,英特尔还准备了一系列课程,以帮助所有人 - 与 - 交易知识,并更轻松地将第一步从0到1,从而为数据奠定了坚实的基础。开发大型模型应用程序的三个要素,硬件平台是基础,英特尔专家总结了大型模型应用程序开发的三个要素。除了软件堆栈并支持今天提到的指南课程外,硬件环境也很重要。该火山引擎已根据英特尔Xeon的英特尔处理器建造了各种云主机。最近,由G4IL的一般目标示例推出,该示例基于Intel Xeon 6 Performance Core Processor,SuipablE对于应用程序的开发。G4IL是火山引擎的第四代一般客观示例,其中“ G”代表一般目标“ 4”代表第四代,而“ I”代表了Intel CPU的平台。与第三代相比,在数据库应用程序,Web应用程序和图像渲染中,其整体性能得到了显着改善,其对AI识别的好处尤其出色。多亏了集成的AMX加速器,Intel Xeon 6处理器已成为最能识别AI的X86建筑处理器之一。在G4IL的火山引擎的示例中,用户可以使用CPU完成AI识别。与基于GPU的解决方案相比,它具有较低成本的好处,并且更容易获得资源,并且可以满足基本需求。基于CPU的破坏解决方案特别适合于AI应用的发展阶段和验证。和上面提到的火山引擎抹布镜,用户是Maait迅速为大型云应用程序开发了一个发展环境,从而大大降低了硬件资源的阈值。当涉及劳动过程时,通常有必要使用CPU + GPU计算的异质体系结构。例如,具有AMX的Xeon CPU可用于处理轻巧的AI负载,例如嵌入,重新排列和矢量数据库,从而使GPU专注于处理重型AI负载,从而改善了资源使用和一般处理能力。 G4IL的亮点是,用户只需要选择配备16个VCPU或32 VCPU的云主机,并且即使不使用GPU,也可以使用具有7或14B的蒸馏版本的型号。值得一提的是,该解决方案还支持DeepSeek BF16推荐的高准确计算格式,这进一步提高了构想的质量。摘要:一旦技术进化就是RapiD,在云平台的帮助下开发不仅降低了反复试验成本,而且还可以加速变化,从而为企业和开发人员提供更灵活的选择。更重要的是,通过完善破布和其他技术,我们可以创建不容易被大型模型“捕获”的AI应用程序。